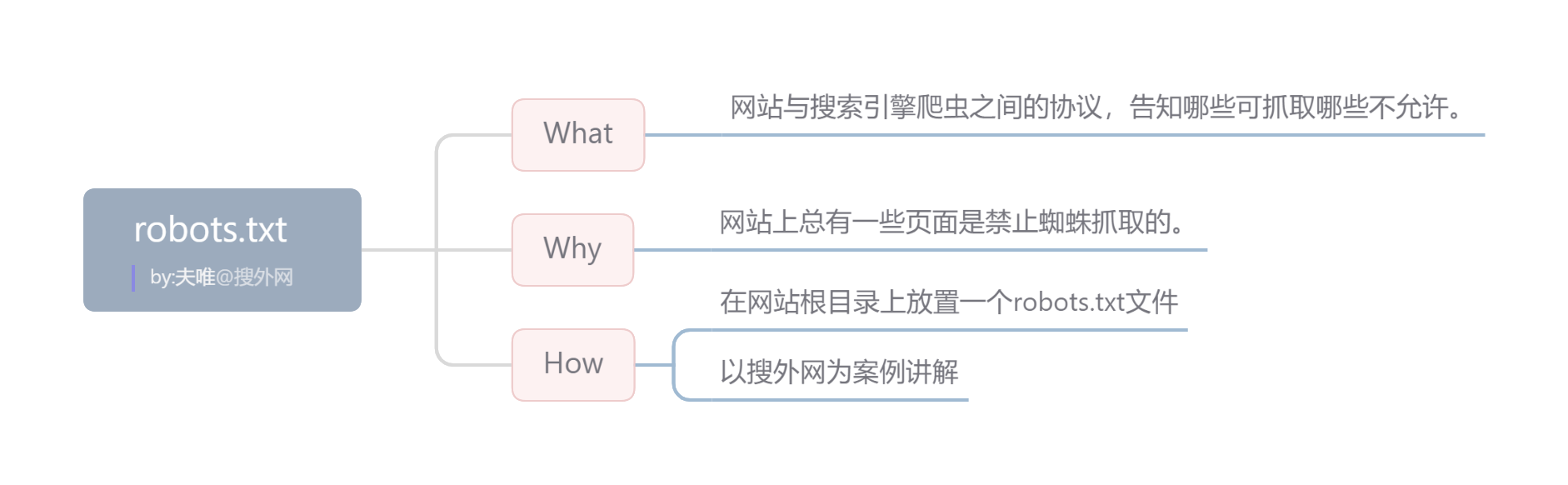

| 什么是robots文件?

Robots是站点与spider沟通的重要渠道,是网站与搜索引擎爬虫之间的协议,告知哪些可抓取哪些不允许。

| 为什么要做robots文件?

网站上总有一些页面是禁止蜘蛛抓取的。例如:搜索页面、筛选页面、后台登录地址等。

| 如何制作 robots文件?

编写robots.txt文件并上传到网站根目录。

| 制作 robots.txt注意事项

● 所有搜索引擎则用星号表示

● Allow(允许)和Disallow(不允许)优先级

● 至少屏蔽一个,可以屏蔽:搜索结果页面/404页面

● 记得将sitemap放到Robots文件中

● 可以陆续放入更多,而不是一次性决定所有

● 网站后台地址/图片地址/下载文件地址/错误链接